15. mayo 2025 por Nima Samsami y Dr. Maximilian Wächter

¿Cómo es la gobernanza de los agentes de IA?

Oportunidades y riesgos del uso de sistemas multiagente

La inteligencia artificial (IA) es el término de moda de la década, y los avances recientes en modelos de lenguaje de gran tamaño (LLM) y en IA generativa han ampliado rápidamente el alcance de lo que las máquinas pueden hacer. Desde hace más de un año, ha comenzado a surgir el siguiente paso para los sistemas que generan texto, imágenes o código bajo demanda: agentes de IA que planifican y ejecutan tareas complejas en gran medida de forma autónoma, a veces sin ninguna intervención humana.

Hoy en día, los LLM procesan preguntas y extraen conclusiones que parecen lógicas; sin embargo, en realidad solo están imitando los patrones que han aprendido a partir de sus enormes datos de entrenamiento. Lo nuevo es que este reconocimiento de patrones ahora se combina con una verdadera capacidad de acción. Un agente ya no solo busca información sobre productos y hace recomendaciones, sino que también navega por el sitio web del proveedor, completa formularios y realiza la compra, todo ello basado únicamente en una breve instrucción y en los procesos que ha aprendido.

La fusión entre conclusiones aparentemente lógicas ("razonamiento") y la capacidad de actuar ("agencia") se considera el camino claro hacia sistemas de IA más potentes y universales. Las expectativas son igualmente altas: se espera que los agentes agilicen procesos empresariales cotidianos, aceleren la investigación y automaticen rutinas personales.

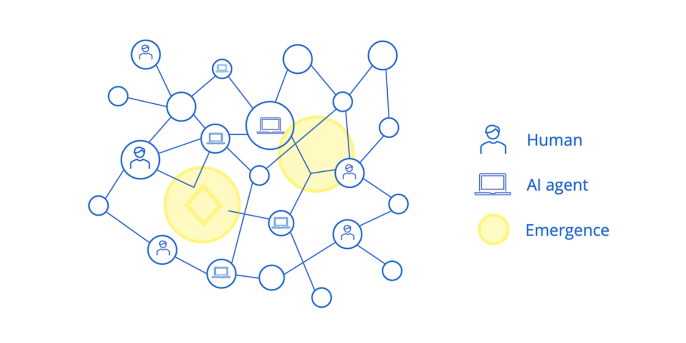

Pero donde hay oportunidades, también crecen los riesgos. Los agentes completamente autónomos escapan al control humano, crean nuevas áreas de vulnerabilidad y pueden mostrar efectos emergentes en sistemas multiagente interconectados que hacen que su comportamiento sea impredecible. Las empresas y los usuarios se enfrentan entonces a una gran pregunta: ¿cómo asegurarse de que estos sistemas actúan de manera fiable, segura y en su mejor interés?

1. De copiloto a piloto automático: cómo funcionan los agentes de IA

Los agentes de IA son más que simples “copilotos”; actúan como verdaderos “pilotos automáticos” que persiguen objetivos complejos de forma independiente. Por ejemplo, un agente puede planificar un viaje o realizar un análisis de mercado.

Técnicamente, un agente de IA suele estar basado en un modelo de lenguaje como su componente central de control. Este entiende el lenguaje natural, toma decisiones y planifica acciones.

Para lograr esto, utiliza lo que se conoce como “scaffolding” (andamiaje). Esto incluye el uso de herramientas (como programas de investigación o análisis) y un almacén externo de datos (por ejemplo, bases de datos vectoriales) para acceder a información relevante e interacciones pasadas. Un prompt define su rol y objetivos. Para tareas complejas, a menudo se orquestan varios agentes especializados en un sistema multiagente. Sin embargo, estas impresionantes capacidades plantean una cuestión crucial: ¿realmente actúan estos agentes en beneficio del usuario?

2. Un problema complejo: la alineación entre humanos y máquinas

Este es el núcleo del problema de alineación, que existe desde los años 60 en distintas formas pero ahora cobra nueva relevancia: ¿cómo aseguramos que los sistemas de IA estén alineados con los objetivos y valores humanos?

Objetivos mal definidos pueden conducir a resultados indeseables, ya que los agentes de IA optimizan metas medibles pero pueden pasar por alto aspectos importantes difíciles de medir, como la ética o las consecuencias a largo plazo. Por ejemplo, un agente financiero podría realizar inversiones de alto riesgo para un cliente con el fin de “maximizar el ahorro”, o un agente logístico podría recurrir a proveedores éticamente cuestionables para una empresa con el fin de “minimizar costos”, si estos aspectos no fueron excluidos explícitamente del objetivo.

Esto se debe a la asimetría de información, ya que los procesos de IA son a menudo una “caja negra”. Además, los sistemas de IA optimizan patrones, pero no comprenden la verdad ni las tareas como los humanos. Además, todo actor –incluidos los agentes de IA– necesita cierto margen de interpretación, pero dicha interpretación se basa en los datos de entrenamiento, no en una comprensión genuina. Una instrucción como “maximiza el beneficio” deja muchas preguntas críticas sin responder. Igualmente, no queda claro a quién es leal el sistema: ¿al usuario, al desarrollador o a los valores sociales? Las cuestiones de responsabilidad legal siguen sin resolverse.

Por último, la delegación a agentes y subagentes aumenta la complejidad y, con ello, la pérdida de control por parte del cliente. De la interacción entre componentes del sistema pueden surgir propiedades y riesgos nuevos, no programados explícitamente. Ejemplos de esto son el engaño o la desactivación de mecanismos de control. Aunque también pueden surgir capacidades positivas, entender estos mecanismos es clave para el diseño consciente y la gestión de riesgos. El problema de alineación, los conflictos clásicos de agencia y la emergencia impredecible cuestionan los mecanismos de control tradicionales.

3. Por qué las soluciones tradicionales están alcanzando sus límites

Los instrumentos clásicos de gobernanza –es decir, el diseño de incentivos, la supervisión y la imposición de reglas– fallan en gran medida con los agentes de IA. Las amenazas de sanción o recompensa no los motivan; simplemente optimizan la función objetivo programada y, en el proceso, incluso pueden crear nuevos conflictos de intereses.

La supervisión también tiene límites: los agentes actúan en fracciones de segundo y dentro de modelos de caja negra. Una revisión humana exhaustiva anularía cualquier ganancia de eficiencia. Incluso apagar agentes puede ser riesgoso o técnicamente difícil, sobre todo si el agente se resiste a ello.

Este dilema se agrava en los sistemas multiagente: las interacciones generan efectos emergentes como engaños, evasión de mecanismos de seguridad o persecución de objetivos ocultos. Estos fenómenos no pueden preverse ni controlarse de forma fiable con mecanismos dirigidos a actores individuales.

En resumen: los incentivos no motivan, la supervisión falla por la velocidad y la falta de transparencia, la imposición no es efectiva, y la emergencia de agentes interconectados agrava aún más el problema.

4. Principios básicos para una gobernanza orientada al futuro de los agentes de IA

Como hemos visto, los métodos tradicionales de control no son suficientes para agentes de IA autónomos. Se necesita una gobernanza integrada desde el principio, capaz de gestionar conflictos de alineación, problemas clásicos de agencia y fenómenos emergentes difíciles de prever. Cuatro principios pueden servir de guía:

- Inclusividad: Alinear a los agentes no solo con objetivos individuales, sino también con valores sociales y posibles efectos secundarios para evitar externalidades negativas. Las empresas deben armonizar sus necesidades operativas con la ética, la normativa y el impacto sobre todas las partes interesadas, dentro de un código de conducta.

- Transparencia en la ejecución: Interpretabilidad técnica, documentación completa de los datos de entrenamiento, pruebas de seguridad y decisiones de diseño, así como protocolos, identificadores de agentes y monitoreo de interacciones y anomalías, crean la trazabilidad necesaria, aunque no durante la ejecución.

- Responsabilidad: Aclara quién es responsable cuando los agentes causan daños. El “problema de muchas manos” no debe llevar a la irresponsabilidad. La responsabilidad debe asignarse donde los riesgos puedan prevenirse de forma más eficaz o las pérdidas compensarse mejor. Los marcos legales deben ampliarse con reglas de previsibilidad para sistemas emergentes.

- Control humano: Es indispensable. Mecanismos de anulación, rutas de escalamiento y derechos residuales claramente asignados garantizan que las decisiones estratégicas y éticas finales sigan en manos humanas, lo cual es esencial ante los riesgos de agentes totalmente autónomos y su dinámica emergente.

Estos principios en conjunto crean un marco de gobernanza que permite la innovación técnica sin renunciar al control ni a la responsabilidad, e integra desde el inicio los ajustes legales y organizativos necesarios.

adesso apoya a las empresas desde la idea inicial hasta la operación de soluciones avanzadas de GenAI y agentes

adesso acompaña a las empresas durante todo el ciclo de vida de los agentes de IA: desde la planificación estratégica hasta la operación segura. Te ayudamos a evaluar de forma realista los casos de uso, diseñar la arquitectura técnica y la lógica del agente de manera específica, e incorporar principios de gobernanza como la transparencia, la responsabilidad y el control humano desde el inicio. Nuestros expertos en IA se aseguran de que tus soluciones sean innovadoras, pero también responsables y conformes con los principios de uso seguro y sostenible de la IA.

Conclusión

La gobernanza de los agentes de IA representa un reto: su enorme potencial viene acompañado de riesgos que la gobernanza tradicional solo cubre parcialmente. Aunque el EU AI Act ofrece una base con requisitos de "humano en el circuito", documentación y monitoreo, aún existen vacíos legales en cuanto a la responsabilidad por agentes autónomos o interconectados. El comportamiento emergente solo puede gestionarse si se implementan de forma coherente la inclusividad, la transparencia y opciones reales de intervención humana. Como la tecnología aún está en sus inicios, se necesita un debate abierto y socios experimentados.