10. septiembre 2024 por Oleg Smolanko

GenAI y su aplicación

La Inteligencia Artificial Generativa (GenAI) ha revolucionado la experiencia tecnológica. Esto quedó claro con el lanzamiento de las arquitecturas Transformer y Attention en el trabajo "Attention is All You Need", que marcó un punto de inflexión decisivo. En su esencia, GenAI permite la creatividad asistida por máquinas al habilitar sistemas para generar contenido de manera autónoma, ya sea en forma de texto a texto, imagen a texto/texto a imagen o video a texto/texto a video. Pero, ¿qué hay detrás de este emocionante campo de la IA? Como se mencionó anteriormente, GenAI se ocupa del desarrollo de modelos capaces de generar nuevos datos y contenido. En el artículo "¿Qué es la IA Generativa?" puedes encontrar una definición detallada, así como ideas y distinciones entre IA, aprendizaje profundo y aprendizaje automático.

La importancia de GenAI

¿Por qué es tan importante GenAI? La respuesta radica en la capacidad de estos sistemas para generar nuevas ideas, desarrollar soluciones y fomentar enfoques innovadores en diversas industrias. Una razón aún más importante para la gran popularidad de GenAI es la capacidad multimodal de estos modelos; es decir, un modelo de lenguaje que antes respondía a nuestras preguntas ahora puede responder no solo a datos textuales, sino también a datos visuales. Por ejemplo, para una imagen de entrada, este modelo puede realizar reconocimiento de objetos, segmentación, entre otras tareas, o para un video, el reconocimiento de conceptos a partir de señales visuales solo con conocimiento general.

Ya existen aplicaciones de GenAI en muchos campos, como en la medicina, donde los modelos ayudan a realizar diagnósticos complejos, o en el procesamiento del habla e imágenes. Pero, ¿hasta dónde pueden llegar estos modelos y para qué casos de uso pueden emplearse? Este artículo aborda esta pregunta en detalle y ofrece una visión general de los casos de uso de GenAI, en particular el manejo de datos visuales y las posibles aplicaciones en visión por computadora.

Esencialmente, GenAI permite la generación de nuevo contenido basado en análisis de datos. A diferencia de los enfoques de IA convencionales, que se basan en datos existentes, GenAI permite la creación de contenido nuevo y original. Estos modelos aprenden patrones y estructuras a partir de datos existentes y pueden generar de manera autónoma contenido similar pero novedoso.

Una de las áreas más importantes de GenAI es la machine vision. En este artículo sobre Computer vision for deep learning - a brief introduction se ofrece una definición integral de visión por computadora y la categorización de esta disciplina en el grupo de aprendizaje profundo.

Estos modelos utilizan enfoques multimodales para procesar tanto información visual como lingüística. Como resultado, no solo pueden reconocer objetos en una imagen, sino también describir el contexto y la relación entre estos objetos, lo que permite un análisis más preciso del contenido visual.

Visión por computadora y GenAI: una visión general

La capacidad multimodal de estos modelos se está implementando de manera particularmente efectiva en la visión por computadora para mejorar o incluso asumir completamente sus posibilidades de aplicación. Estos modelos, conocidos como "LLMs visuales", se dividen en tres categorías diferentes según sus datos de entrada. Existen modelos que:

- 1. Trabajan exclusivamente con imágenes estáticas.

- 2. Pueden procesar tanto imágenes estáticas como videos sin sonido.

- 3. También pueden trabajar con datos de audio

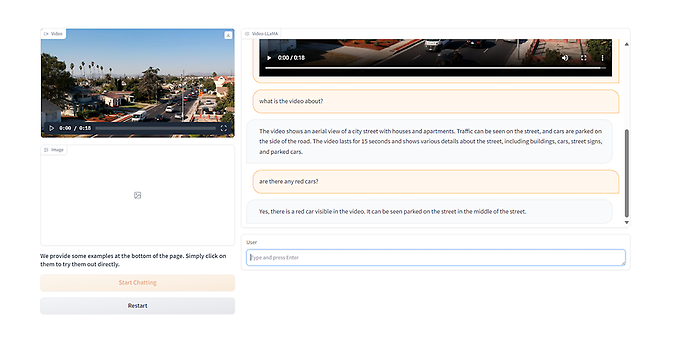

Un modelo ejemplar en este contexto es el modelo Video-LLaMa, un modelo de lenguaje multimodal que puede comprender tanto el contenido visual como el de audio de un video. Se muestra una demostración práctica de este modelo con diversas preguntas de comprensión visual en la imagen adjunta.

Video-LLaMa, source: https://huggingface.co/spaces/DAMO-NLP-SG/Video-LLaMA

Dependiendo del formato de entrada - video o imagen - el modelo Video-LLaMa, que puede manejar ambos formatos, ofrece una variedad de posibilidades, desde la interpretación de datos visuales hasta la captura de dinámicas temporales en videos.

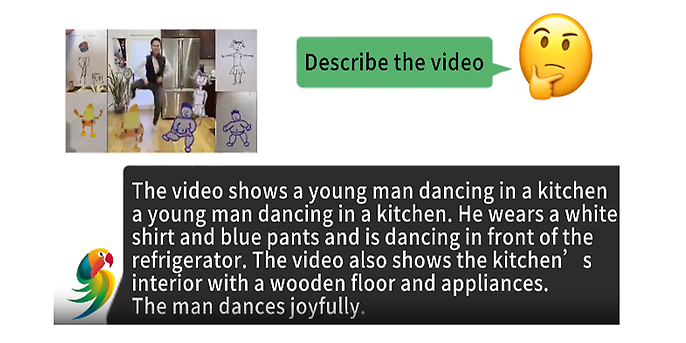

Además del Video-LLaMa, los modelos que trabajan exclusivamente con imágenes estáticas incluyen variantes como ChatGPT, en particular Mini-GPT4, la serie de modelos LLaVA que incluye LLaVA-Plus, LLaVA-Med o LLaVA incluyendo BLIP-2. Como se puede ver en la imagen, estos modelos pueden realizar varias tareas de visión por computadora usando VideoChat como ejemplo. El modelo es capaz de realizar tareas como el reconocimiento de objetos o la identificación de objetos y generar diferentes contenidos basados en imágenes de entrada, como recetas, memes, textos publicitarios o textos literarios. Además, el rango de objetos reconocidos para el reconocimiento e identificación de objetos se está ampliando constantemente. Como ya se mencionó en la introducción, GenAI también se usa en medicina. Un ejemplo en esta categoría es el modelo LLaVA-Med, que se basa en datos biomédicos visuales y puede realizar respuestas a preguntas en forma de conversaciones o descripciones detalladas.

Sin embargo, también existen modelos que pueden procesar tanto imágenes estáticas como datos de video sin sonido, como Video-ChatGPT y VideoChat. Algunos ejemplos de estos modelos se muestran en la figura a continuación. Además, estos modelos permiten responder preguntas basadas en imágenes y videos de entrada.

VideoChat, source: https://github.com/OpenGVLab/Ask-Anything

Como muestran los ejemplos, estos modelos son versátiles y pueden realizar una amplia gama de tareas. Desde la comprensión de videos y tareas conversacionales hasta la interpretación de memes o recetas, demuestran sus impresionantes capacidades solo con entrada visual. Algunos modelos incluso son capaces de convertir un borrador escrito a mano en un sitio web completo.

El futuro de GenAI: ¿hacia dónde se dirige?

Pero solo estamos al principio de esta era. La pregunta de hasta dónde pueden llegar estos modelos aún queda en el futuro. Su potencial hasta ahora deja margen para especular sobre las alturas innovadoras que todavía pueden alcanzar. Por otro lado, si observamos la rápida evolución de estos modelos en la visión por computadora, queda claro que el progreso avanza a un ritmo sorprendente. Desde los modelos tradicionales de visión por computadora, como las arquitecturas AlexNet o ResNet, hasta el Vision-Transformer (ViT) y los LLMs visuales actuales, la evolución ha sido increíblemente rápida.

El Transformer es un modelo innovador para la visión artificial basado en el enfoque de modelado del Transformer. A diferencia de las redes neuronales convolucionalesCNNs, los Vision Transformers no utilizan jerarquías fijas de bloques de extracción de características. En su lugar, tratan la imagen como una secuencia de parches, lo que permite que el modelo de Vision Transformer capture de manera eficiente tanto la información global como la local. El modelo Transformer en sí tiene una aplicación más amplia y fue introducido en 2017 porVaswani et al.

Ha demostrado ser revolucionario para procesar secuencias en diversas aplicaciones, como la traducción automática, la generación de texto y las tareas de procesamiento del lenguaje natural. En comparación con arquitecturas anteriores, el Transformer no utiliza el operador 'recurrente' en Recurrent Neural Networks(RNNs) o el operador 'convolucional' en lasConvolutional Neural Network (CNNs). En cambio, el Transformer utiliza el mecanismo de atención, que permite al modelo acceder a todas las partes de la secuencia de entrada simultáneamente. Esto mejora significativamente la eficiencia y la paralelización en comparación con las RNN. Los Transformers pueden procesar tanto datos secuenciales como no secuenciales, como las imágenes en las arquitecturas de Vision Transformer.

Ante este desarrollo de los LLM visuales, surge la pregunta: ¿Todavía necesitamos estos modelos tradicionales en el contexto de la visión por computadora? No se puede dar una respuesta general. De hecho, los modelos "state of the art" eran modelos basados en ViT que realizaban algunas tareas de visión por computadora sin necesidad de un entrenamiento específico en CNN. Un ejemplo de esto es el modelo ViLT, que, como se muestra en el artículo, puede realizar tareas de reconocimiento de objetos, entre otras.

Por otro lado, es importante examinar más de cerca las arquitecturas de todos estos LLM visuales. Los componentes basados en ViT son una parte integral de estos modelos. Estos modelos tradicionales aún juegan un papel importante en el desarrollo continuo de los LLM visuales. Hasta ahora, los experimentos con arquitecturas se han realizado solo de manera limitada.

Sin embargo, un cambio significativo y significativo en la arquitectura podría ayudar a aumentar sustancialmente el rendimiento de estos LLM visuales. La capacidad no solo de entender datos visuales, sino también de colocarlos en un contexto lingüístico, ha ampliado los límites de lo posible. El impulso de estos avances sugiere que podemos esperar muchos más desarrollos asombrosos en el futuro.

Conclusión: GenAI como pionera para el futuro de la IA

GenAI y los modelos multimodales han demostrado una versatilidad impresionante que se manifiesta en diversas áreas como la visión artificial o el procesamiento del habla. Estos modelos ofrecen soluciones creativas y oportunidades para la innovación. El desarrollo futuro sigue siendo abierto, y se especula sobre las alturas que estos modelos aún pueden alcanzar en su capacidad innovadora. El rápido desarrollo, desde los modelos tradicionales de visión por computadora hasta los LLM visuales, sugiere que se puede esperar un mayor progreso. GenAI no es solo tecnología, sino un viaje multifacético a través de la creatividad y la innovación.

GenAI

De la idea a la implementación

GenAI cambiará nuestra vida empresarial tanto como lo hicieron Internet o los negocios móviles. Hoy en día, empresas de todos los tamaños y sectores están sentando las bases para el uso efectivo de esta tecnología en sus negocios.

Un desafío clave: integrar las aplicaciones de GenAI en sus propios procesos y en el panorama de TI existente. Puedes descubrir cómo hacerlo y cómo podemos apoyarte en nuestra página web.