5. febrero 2026 por Dr. Michael Peichl

Lo mejor de dos mundos: el conocimiento de procesos de SAP se une a la potencia de IA de Databricks

En la práctica empresarial, los roles suelen estar claramente definidos: SAP actúa como system of record, la fuente oficial y fiable de las transacciones. Sin embargo, cuando se trata de aplicar IA generativa, mantenimiento predictivo o análisis de datos no estructurados, la arquitectura clásica de SAP suele alcanzar sus límites.

¿Por qué usar Databricks para datos SAP?

La respuesta está en la especialización.

SAP es imbatible en estabilidad de procesos y datos financieros estructurados.

Databricks ofrece el entorno ideal para machine learning moderno: entrenamiento con GPU, data science en Python y despliegue de LLMs abiertos.

El reto histórico ha sido conectar ambos mundos sin generar nuevos silos de datos.

Hasta ahora, esto implicaba complejos pipelines ETL: altos costes de desarrollo, duplicación de almacenamiento y latencia. Cuando un informe solo está disponible al día siguiente, las decisiones se toman con datos desactualizados.

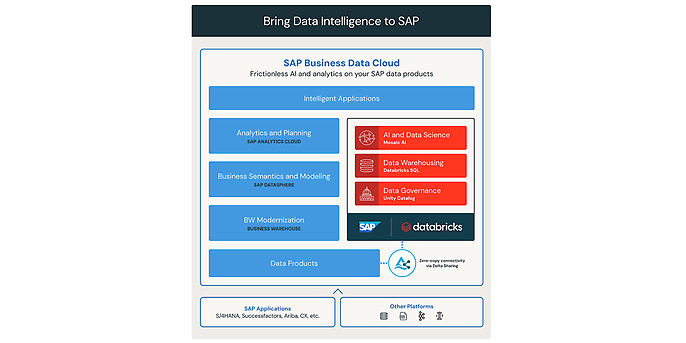

La alianza estratégica entre SAP y Databricks introduce nuevos patrones de integración que eliminan esa latencia a nivel arquitectónico y aplican la potencia de IA directamente sobre los datos SAP.

El cambio tecnológico: acceso lógico en lugar de copias físicas

La solución reside en la virtualización del acceso a los datos. Habilitada técnicamente por el protocolo abierto Delta Sharing, la forma en que se suministran los datos cambia de manera fundamental.

En lugar de extraer, transportar y volver a almacenar físicamente los datos, el Databricks Lakehouse accede de forma lógica a los data products en SAP Datasphere. Para los científicos de datos y analistas, parece que la información estuviera almacenada localmente en el Lakehouse; sin embargo, físicamente permanece de forma segura en el sistema SAP.

Zero-copy architecture / delta sharing, Fuente: Introducing SAP Databricks | Databricks Blog)

Decisión arquitectónica: virtualización vs. ingestión

Esto ofrece tres ventajas arquitectónicas clave:

- Evitar la redundancia: Reducimos significativamente los costes de almacenamiento y de salida de datos (egress), ya que no es necesario crear copias duplicadas solo para fines analíticos.

- Preservación de la semántica: No se extraen únicamente tablas técnicas crípticas como KNA1 (maestro de clientes) o MARA (maestro de materiales), sino también los modelos semánticos. La lógica de negocio y las relaciones entre objetos de datos se mantienen intactas y no deben reconstruirse manualmente en Databricks.

- Tiempo real en lugar de “datos de ayer”: Al eliminar los procesos de copia física, los análisis trabajan siempre con los datos más actualizados. La latencia entre el registro en SAP y su visualización en el dashboard se reduce a cero.

Estrategia de implementación: ¿virtualización o ingestión?

Databricks proporciona la tecnología, pero la decisión arquitectónica depende del caso de uso. No existe una solución única válida para todo.

En los proyectos modernos se distingue claramente según el escenario:

- El camino virtual (Zero Copy)

Es el estándar preferido para Business Intelligence y análisis ad hoc.

Si un controller desea ver la facturación actual, el acceso virtual es ideal: rápido, actualizado y rentable. - El camino físico (Lakeflow Connect)

Existen escenarios en los que la virtualización alcanza sus límites —por ejemplo, al entrenar modelos complejos de IA que requieren snapshots históricos o generan grandes cargas de I/O—.

En estos casos se utilizan conectores nativos mediante Lakeflow para transferir los datos de forma incremental y con seguridad transaccional (ACID) a Delta Lake.

El arte de la ingeniería consiste en combinar ambos enfoques dentro de una arquitectura híbrida que permita obtener lo mejor de ambos mundos.

Seguridad a través de las fronteras del sistema

La apertura técnica de los datos SAP suele generar inquietudes en los responsables de seguridad. Para evitar brechas de gobernanza, Unity Catalog actúa como instancia central de control.

La ventaja de esta arquitectura es la sincronización:

- Las políticas de seguridad y los metadatos pueden gestionarse de forma coherente entre sistemas. Esto garantiza un data lineage consistente.

- Es técnicamente posible demostrar qué registro de SAP alimenta qué modelo de IA o qué dashboard.

- Los derechos de acceso se aplican de forma centralizada, independientemente de si el acceso se realiza mediante código Python o consultas SQL.

En la siguiente parte de la serie analizaremos cómo implementar estos requisitos de gobernanza en la práctica:

“Unity Catalog en la práctica: cómo combinar finalmente democracia del dato y cumplimiento normativo alemán”.

El resultado: valor estratégico y excelencia operativa

¿Por qué asumir este esfuerzo arquitectónico? La respuesta es doble:

Por un lado, se obtienen ventajas estratégicas que no serían posibles en un entorno exclusivamente SAP.

Por otro, se proporcionan a las áreas de negocio nuevas herramientas operativas de gran impacto.

1. El impulso estratégico: ¿por qué conectar SAP con Databricks?

La combinación de ambas plataformas genera sinergias que van mucho más allá del reporting tradicional.

- Datos estructurados + datos no estructurados (visión 360°):

SAP domina los datos transaccionales estructurados.

Databricks lidera en datos no estructurados (PDFs, imágenes, logs IoT).

Solo al vincular los datos maestros de SAP con esta información adicional surge el contexto necesario para una IA real.

Por ejemplo, cuando un agente no solo detecta una caída en ingresos, sino que también analiza los correos electrónicos de clientes insatisfechos asociados a ese caso. - Time-to-value para IA:

Los data scientists acceden de inmediato a datos productivos en un entorno optimizado para machine learning (Python, GPUs, LLMs).

Sin proyectos complejos de extracción, los pilotos de IA pueden probarse en días en lugar de meses.

2. El beneficio operativo: dos caminos hacia la asistencia con IA

Una vez establecida la base, los reportes estáticos pueden sustituirse por asistentes inteligentes. Según la complejidad del requisito, existen dos opciones:

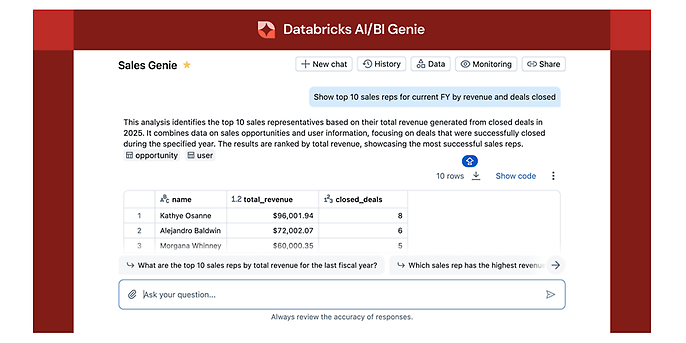

- Camino A: Análisis ad hoc con AI/BI Genie

Para preguntas de negocio clásicas, las áreas funcionales utilizan AI/BI Genie. Interactúan directamente con los datos en lenguaje natural:

“Analiza la evolución del margen del grupo de productos ‘componentes de maquinaria’ en el Q3 y muéstrame las razones de la desviación.”

El sistema no solo genera texto, sino también visualizaciones automáticas, reconoce relaciones complejas y aprende del feedback.

La ventaja: auténtico self-service analytics, sin que IT tenga que desarrollar un nuevo reporte para cada pregunta.

Fuente: Databricks AI/BI Genie, AI/BI Genie | Databricks Blog )

- Camino B: Agentes personalizados

Cuando se requiere lógica específica o integración con workflows complejos, el Mosaic AI Agent Framework permite desarrollar agentes especializados que no solo analizan, sino que ejecutan acciones.

Confianza mediante capa semántica certificada

Uno de los riesgos de la IA generativa son las “alucinaciones”. Un modelo no conoce por defecto cómo se define internamente el EBITDA o el margen de contribución.

Para evitarlo, se implementan metric views en Unity Catalog, donde la lógica de cálculo se define como única fuente oficial.

El resultado: cifras fiables y coherentes con los reportes oficiales de SAP.

Conclusión

La arquitectura moderna elimina el falso dilema entre estabilidad (SAP) e innovación (Databricks).

Gracias al enfoque zero-copy y a una gobernanza centralizada, es posible construir una infraestructura ágil para IA sin comprometer la integridad del dato maestro.