3. diciembre 2025 por Ellen Tötsch

Más que chatbots: conciliación inteligente de documentos con Gemini

Cuando se piensa en los casos de uso de los grandes modelos de lenguaje (LLM) como Gemini, GPT o Claude, lo primero que suele venir a la mente son las aplicaciones de chat. No es casualidad: fue ChatGPT quien revolucionó el mercado a finales de 2022 y transformó para siempre el trabajo de los ingenieros de machine learning.

Sin embargo, limitar los LLM únicamente al chat significa desaprovechar gran parte de su potencial. Estos modelos no solo pueden conversar, sino también generar resultados estructurados y fiables. Gracias a los output schemas, ya no es necesario “pedir por favor”: es posible exigir el cumplimiento exacto de una estructura, por ejemplo en formato JSON.

Uno de los campos de aplicación más interesantes más allá del chat es la conciliación automática de documentos.

hagebau y el reto de la conciliación documental

Este potencial fue precisamente el eje central de las reflexiones del grupo de compras hagebau. Como grupo internacional de gran tamaño, hagebau se enfrenta a diario al reto de optimizar sus procesos sin perder el enfoque en el asesoramiento personalizado y orientado al cliente.

Uno de los mayores problemas era la comparación manual de pedidos y confirmaciones de pedido, un proceso lento y propenso a errores: el escenario perfecto para aplicar LLM y aumentar la eficiencia reduciendo la carga de trabajo de los empleados.

Cuando los socios de hagebau —como la innovadora Bauwelt Delmes Heitmann— realizan pedidos, los datos procedentes del sistema ERP deben compararse con la confirmación de pedido. Una tarea tediosa que requiere máxima atención. Como sabe cualquiera que haya construido una casa, incluso pequeñas desviaciones en ventanas o puertas pueden dar lugar a productos totalmente inutilizables.

Hasta ahora, esta conciliación consumía mucho tiempo del equipo operativo. A pesar del máximo cuidado, el error humano no podía eliminarse por completo. El objetivo era claro: aliviar a los empleados y crear una herramienta inteligente que hiciera este proceso mucho más eficaz, permitiendo a los equipos centrarse más en el cliente y dedicar tiempo a la atención personalizada.

Con un departamento propio de IA y modelos GPT para aplicaciones internas, hagebau ya es uno de los pioneros del sector. Sin embargo, este caso demostró que no todos los casos de uso pueden resolverse únicamente con recursos internos.

Para la comparación automatizada de documentos, quedó claro rápidamente que era necesario un apoyo tecnológico adicional. Por ello, hagebau, Bauwelt Delmes Heitmann y adesso desarrollaron conjuntamente una solución basada en IA que mejora significativamente la eficiencia del proceso.

Un equipo de ingenieros de GenAI y UI de adesso diseñó un sistema semiautomatizado de conciliación documental, ejecutado de forma nativa en Google Cloud. El protagonista: Gemini 2.5 Flash.

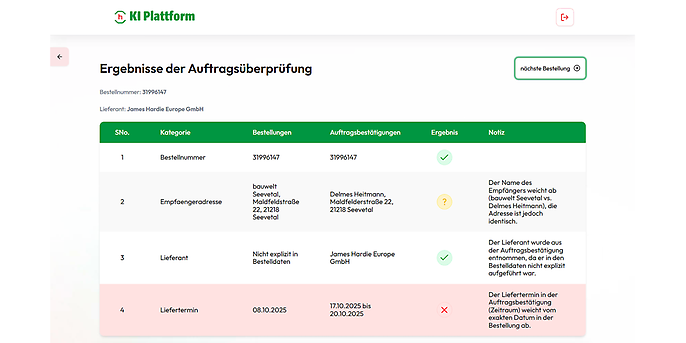

Para ofrecer a los socios una visión rápida de las discrepancias relevantes, los resultados se muestran en una tabla estructurada, desglosada por criterios como:

- Dirección de entrega

- Descripción del artículo

- Precio unitario

La primera columna contiene los datos del pedido y la segunda los de la confirmación. Un icono indica si la información coincide, difiere o es ambigua.

Por ejemplo, si ambas direcciones de entrega son iguales pero una utiliza la razón social completa y la otra el nombre registrado, el sistema marca el caso como dudoso y deja la decisión final al usuario.

adesso & Google Cloud

Strong partners para tu futuro digital

Como Premier Partner certificado de Google Cloud, adesso combina más de 20 años de experiencia con tecnología puntera: desde migraciones cloud hasta big data, IA y soluciones avanzadas de IA generativa. Con más de 1.100 proyectos realizados y un equipo de más de 100 expertos cloud, diseñamos trayectorias cloud seguras, eficientes y adaptadas a cada cliente.

Por qué este caso requería un LLM y no reglas tradicionales

Para entender por qué se optó por una solución basada en LLM, es clave analizar cómo se utiliza Gemini:

- Un system prompt define con precisión la tarea y el proceso

- Un output schema obliga a devolver resultados en JSON, necesarios para la visualización en tabla

- La temperatura del modelo se fija en 0, eliminando cualquier creatividad innecesaria

A diferencia de soluciones basadas en reglas, el LLM reconoce desviaciones semánticas de forma nativa: entiende que formulaciones distintas pueden significar lo mismo, incluso cuando faltan artículos o se usan sinónimos.

Además, puede explicar de forma breve y comprensible por qué algo es o no una discrepancia, algo prácticamente imposible sin modelos de lenguaje.

Los socios también pueden mantener su propio glosario de abreviaturas y sinónimos, asignado por tenant ID, lo que mejora aún más la precisión.

Interfaz de usuario de la conciliación documental con IA: Gemini reconoce que varias posiciones detalladas del archivo CSV corresponden a una única posición consolidada en el PDF.

El documento estaba dividido en varias posiciones en otro archivo. La explicación breve y concisa de por qué algo es o no una desviación solo es posible de esta manera gracias al LLM.

Además, los socios pueden mantener su propio glosario de abreviaturas y sinónimos, lo que ayuda al LLM a comprender aún mejor las diferencias. Estos términos se reconocen y asignan según el tenant ID.

Gemini 2.5 Flash: una decisión estratégica

La elección de Gemini 2.5 Flash no fue casual:

- Excelente rendimiento en OCR, incluso con documentos no optimizados o manuscritos

- Modelo “pensante”, capaz de razonar en varios pasos

- Liderazgo del mercado en cálculo matemático

Gemini puede calcular y comparar precios totales a partir de precios unitarios, cantidades y descuentos, incluso cuando los documentos utilizan métricas distintas (por ejemplo, número de ventanas frente a metros cuadrados).

Implementación técnica del POC

La interfaz de usuario se integra en una plataforma on-premise existente de hagebau. El backend se ejecuta como contenedor en Google Cloud Run.

El endpoint recibe:

- Los dos documentos

- El nombre del socio

- El número de pedido

A partir de ahí:

- Se extrae la información relevante

- Se carga el glosario del socio

- Se envían documentos, prompt y esquema a Gemini

- Se devuelve el resultado estructurado para la tabla

Roadmap: del MVP al futuro

El feedback inicial de los testers ha sido muy positivo. El MVP se desplegará a mayor escala e incluye mejoras como:

- Reconocimiento del número de pedido:

En el POC, los números de pedido siempre debían introducirse manualmente. Para acelerar y simplificar el uso, en el futuro los números de pedido se leerán directamente de los documentos mediante Gemini. Solo si no se puede identificar ningún número, se solicitará al usuario que lo introduzca manualmente. Dado que la extracción de números de pedido en el MVP es menos compleja y debe ser especialmente rápida, en este caso se utiliza el modelo aún más rápido y económico Gemini 2.5 Flash-Lite. - Carga múltiple de documentos (Multiupload):

Hasta ahora, solo podían cargarse los documentos correspondientes a un único pedido. En el MVP será posible procesar varios pedidos de forma simultánea. Para ello, los documentos se cargarán primero en el almacenamiento en la nube. A continuación, Firestore registrará qué pedidos ya disponen de datos, qué información falta y cuál es el estado de la comparación. - Formatos de archivo adicionales:

Originalmente, la comparación de documentos solo podía procesar exportaciones del ERP en formato CSV y confirmaciones de pedido en PDF. Tras consultar con los testers, quedó claro que esto no era suficiente. Por ello, en el MVP se podrán procesar formatos de archivo adicionales. - Mejora de la interfaz de usuario:

Gracias al feedback detallado obtenido durante la fase de pruebas, se identificaron varios puntos en los que la interfaz de usuario puede hacerse más intuitiva y fácil de usar.

Incluso después de implementar las funcionalidades actualmente acordadas para el MVP, ya existen planes para posibles mejoras futuras:

- Importación automática de datos durante la noche:

La automatización completa de la importación de datos, mediante la exportación nocturna de los pedidos a Google Cloud, reduciría significativamente el esfuerzo para los usuarios y aumentaría la eficiencia de la comparación de documentos. - Umbrales personalizados:

En el proof of concept, los usuarios ya pueden mantener su propio glosario. En el futuro, también podrán definir límites individuales, por ejemplo, a partir de qué desviación de precio debe considerarse una discrepancia. Esto aumentará la tasa de aciertos y reducirá el tiempo necesario por parte de los usuarios. - Acceso a comparaciones y documentos históricos:

Otra posible mejora futura es la posibilidad de acceder al historial de comparaciones realizadas y a los documentos originales.

Esta solución semiautomatizada de comparación de documentos demuestra que los LLM como Gemini son capaces de mucho más que chatbots y RAG (retrieval augmented generation). Gracias a la precisión de Gemini en OCR, razonamiento analítico y cálculo, adesso ha podido desarrollar una solución cloud-native que ahorra al cliente una enorme cantidad de trabajo y facilita la transferencia de conocimiento.